La revolución de la IA Generativa ya está aquí.

¿Está preparado? Nosotros lo estamos.

Durante años, la Inteligencia Artificial (IA) y el Aprendizaje Automático (AM) han transformado sectores, mejorado vidas y abordado problemas globales complejos. Estas fuerzas generadoras de cambio, anteriormente identificadas como HPC (computación de alto rendimiento), han impulsado innovaciones digitales en organizaciones de todos los tamaños, aumentando la productividad, la eficiencia y la destreza en la resolución de problemas.

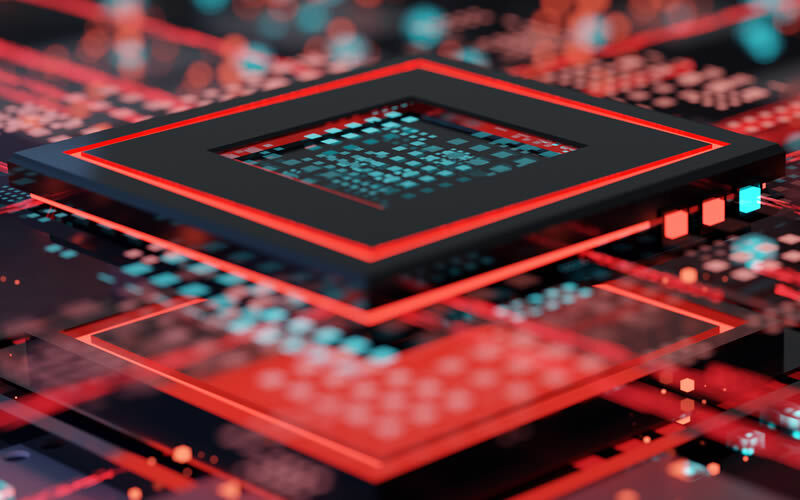

La aparición de modelos de IA Generativa (GenAI), impulsados por el aprendizaje profundo y las redes neuronales, y en general la dinámica en innovaciones de infraestructura de IT, está cambiando aún más el juego. El aumento del uso de estas aplicaciones de Aprendizaje Automático (ML) y GenAI, que llevan a un uso intensivo de los datos y de la computación, está imponiendo exigencias sin precedentes en la infraestructura de los Centros de Datos, requiriendo así una transmisión fiable de gran ancho de banda y baja latencia, densidades de cableado y alimentación de bastidores significativamente mayores y métodos de refrigeración avanzados.

La IA avanzada exige un replanteamiento del diseño de los Centros de Datos

A medida que los Centros de Datos se preparan para la GenAI, los usuarios necesitan soluciones de infraestructura de red innovadoras y sólidas que les ayuden a diseñar, implementar y escalar fácilmente tejidos de red back-end, front-end y de almacenamiento para entornos complejos de IA de computación de alto rendimiento (HPC).

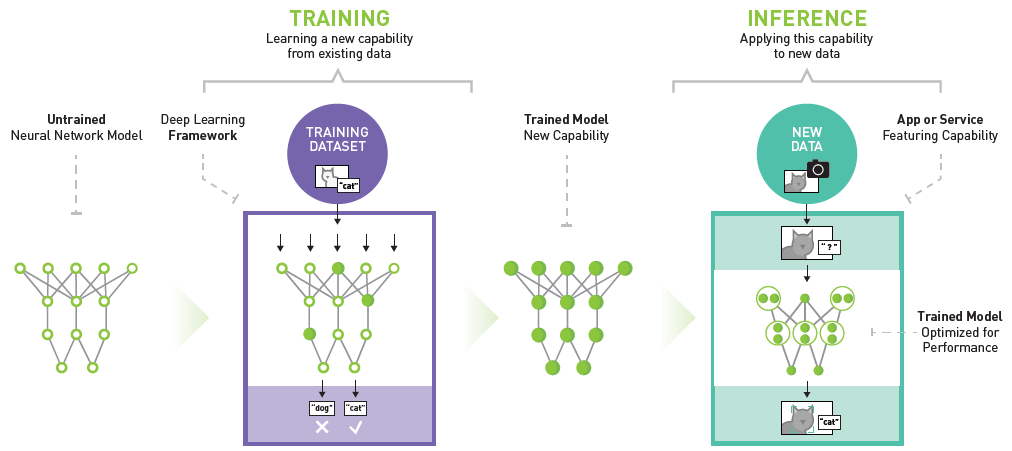

Ejemplo de plataforma de inferencia de aprendizaje profundo de NVIDIA

Los modelos acelerados de GenAI y ML consisten en entrenamiento (aprendizaje de nuevas capacidades) e inferencia (aplicación de las capacidades a nuevos datos). Estas redes neuronales y de aprendizaje profundo imitan la arquitectura y la función del cerebro humano para aprender y generar contenido nuevo y original basado en el análisis de patrones, matices y características a través de conjuntos de datos masivos y complejos. Los grandes modelos lingüísticos (LLM), como ChatGPT y Google Bard, son ejemplos de estos modelos de GenAI entrenados en grandes cantidades de datos para comprender y generar respuestas claras y acertadas. Las Unidades Centrales de Procesamiento (CPU) de propósito general que realizan operaciones de control y entrada/salida en secuencia no pueden extraer con eficacia grandes cantidades de datos en paralelo de diversas fuentes y procesarlos con la suficiente rapidez.

Por tanto, los modelos ML y GenAI acelerados se basan en unidades de procesamiento gráfico (GPU) que utilizan el procesamiento paralelo acelerado para ejecutar miles de cálculos de alto rendimiento de forma simultánea. La capacidad de cálculo de un solo servidor basado en GPU puede igualar el rendimiento de docenas de servidores tradicionales basados en CPU.

Asesor de soluciones NVIDIA

Siemon anuncia soluciones de emparejamiento óptico para redes GenAI que utilizan cálculo acelerado NVIDIA.

Charla técnica a la carta: ¿Cuál es el impacto de la IA Generativa en las infraestructuras?

Nuestros expertos en GenAI aportan la claridad que tanto se necesita en este tema tan cambiante, mostrando ejemplos demostrables de cómo adaptar sus diseños de arquitectura de red para satisfacer mejor los requisitos de formación e inferencia.

Seguir leyendoSiemon está preparado para la IA

Siemon está en la frontera de la revolución GenAI y, gracias a la colaboración con nuestros clientes y socios, que están a la vanguardia de estas tecnologías, hemos desarrollado una gama de soluciones AI-Ready de próxima generación que están más que listas para respaldarle.

Arquitecturas y aplicaciones emergentes de redes de centros de datos de IA

Explore Siemony descubra soluciones de vanguardia preparadas para la IA y diseñadas para arquitecturas de centros de datos emergentes. Descubra el cableado y la conectividad de alto rendimiento para cargas de trabajo de IA y HPC sin interrupciones.

Seguir leyendo