La révolution de l’IA générative est arrivée.

Êtes-vous prêts ? Nous sommes.

Depuis des années, l’intelligence artificielle (IA) et l’apprentissage automatique (ML) remodèlent les industries, améliorent les conditions de vie et s’attaquent à des problèmes mondiaux complexes. Ces forces transformatrices, anciennement identifiées comme HPC (calcul de haute performance), ont alimenté les transformations numériques dans les organisations de toutes tailles, stimulant la productivité, l’efficacité et les prouesses de résolution de problèmes.

L’émergence de modèles d’IA générative (GenAI) très innovants, alimentés par l’apprentissage profond et les réseaux neuronaux, vient encore perturber la donne. L’utilisation accrue de ces applications ML et GenAI à forte intensité de données et de calcul impose des exigences sans précédent à l’infrastructure des centres de données, nécessitant une transmission de données fiable à large bande passante et à faible latence, des densités de câblage et d’alimentation des racks nettement plus élevées, ainsi que des méthodes de refroidissement avancées.

L’IA avancée nécessite de repenser la conception des centres de données

Alors que les centres de données se préparent à la GenAI, les utilisateurs ont besoin de solutions d’infrastructure réseau innovantes et robustes qui les aideront à concevoir, déployer et faire évoluer facilement les réseaux back-end, front-end et de stockage pour les environnements complexes de calcul haute performance (HPC) et d’intelligence artificielle.

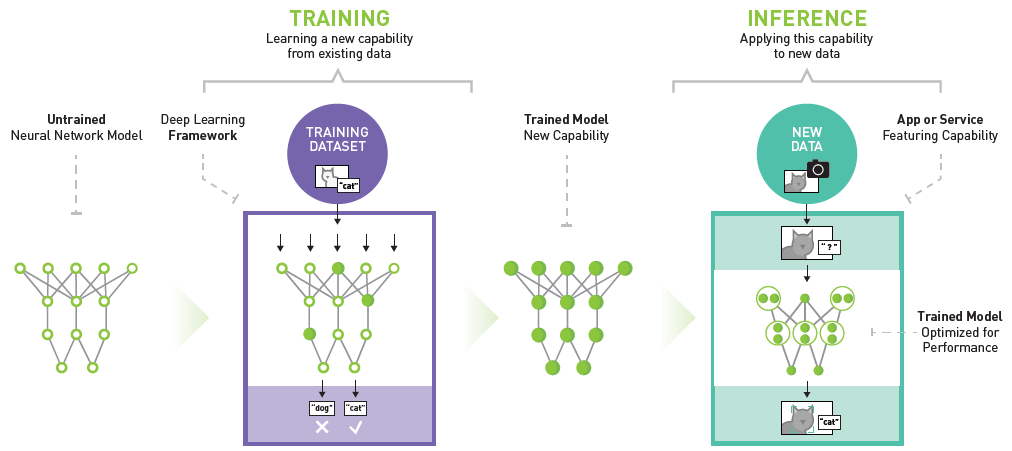

Exemple de plate-forme d’inférence NVIDIA Deep Learning

Les modèles accélérés de GenAI et de ML consistent en une formation (apprentissage de nouvelles capacités) et une inférence (application des capacités à de nouvelles données). Ces réseaux neuronaux et d’apprentissage en profondeur imitent l’architecture et la fonction du cerveau humain pour apprendre et générer un contenu nouveau et original basé sur l’analyse de modèles, de nuances et de caractéristiques dans des ensembles de données massifs et complexes. Les grands modèles linguistiques (LLM), tels que ChatGPT et Google Bard, sont des exemples de ces modèles GenAI formés sur de vastes quantités de données pour comprendre et générer des réponses linguistiques plausibles. Les unités centrales polyvalentes qui effectuent des opérations de contrôle et d’entrée/sortie en séquence ne peuvent pas extraire efficacement de vastes quantités de données en parallèle à partir de diverses sources et les traiter suffisamment rapidement.

Par conséquent, les modèles ML et GenAI accélérés reposent sur des unités de traitement graphique (GPU) qui utilisent un traitement parallèle accéléré pour exécuter simultanément des milliers de calculs à haut débit. La capacité de calcul d’un seul serveur à base de GPU peut égaler les performances de dizaines de serveurs traditionnels à base de CPU !

Conseiller en solutions NVIDIA

Siemon Annonce des solutions de patch optique pour les réseaux GenAI utilisant le calcul accéléré de NVIDIA.

Conférence technique à la demande : Quel est l’impact de l’IA générative sur votre infrastructure ?

Nos experts GenAI apportent les éclaircissements nécessaires sur ce sujet en pleine évolution, en présentant des exemples concrets de la manière dont vous pouvez adapter vos conceptions d’architecture de réseau pour répondre au mieux aux exigences de la formation et de l’inferencing.

En savoir plusSiemon est prêt pour l’IA

Siemon est à la frontière de la révolution GenAI et grâce à la collaboration avec nos clients et partenaires, qui sont à l’avant-garde de ces technologies, nous avons développé une gamme de solutions AI-Ready de nouvelle génération qui sont prêtes à soutenir vos déploiements.

Architectures et applications émergentes des réseaux de centres de données d’IA

Explorez les solutions de pointe de Siemonprêtes pour l'IA et conçues pour les architectures de centres de données émergentes. Découvrez le câblage et la connectivité haute performance pour des charges de travail AI et HPC transparentes.

En savoir plus