Neue Technologien und eine steigende Anzahl von Anwendungen und Datenmengen, die eine hohe Bandbreite, niedrige Latenzzeiten und hochgradig virtualisierte Umgebungen erfordern, treiben die Komplexität von Rechenzentren und die Dichte der Glasfaserverkabelung auf ein neues Rekordniveau.

Veränderte Architektur bedeutet mehr Infrastruktur

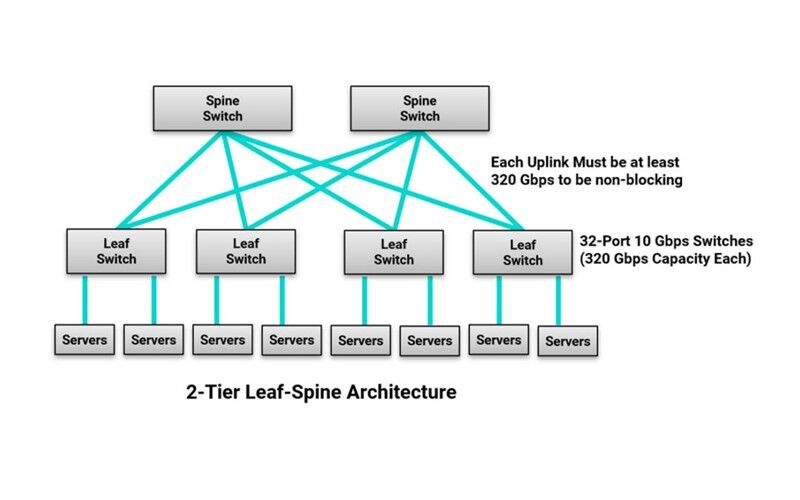

Während die Glasfaserdichte im Rechenzentrum aufgrund der schieren Menge an Geräten, die zur Unterstützung neuer Anwendungen und wachsender Datenmengen benötigt werden, zunimmt, wird sie auch durch die Servervirtualisierung vorangetrieben, die es ermöglicht, Arbeitslasten überall im Rechenzentrum zu verschieben. Die zunehmende Virtualisierung führt zu einer schnellen Migration von der traditionellen dreistufigen Switch-Architektur mit einem Nord-Süd-Verkehrsmuster zu einer Leaf-Spine-Switch-Fabric-Architektur mit nur einer oder zwei Switch-Stufen und einem Ost-West-Verkehrsmuster.

In einer Leaf-Spine-Architektur ist jeder Leaf-Switch mit jedem Spine-Switch verbunden, so dass nie mehr als ein Switch zwischen zwei Leaf-Switches im Netzwerk liegt. Dadurch verringert sich die Anzahl der Switches, die der Datenverkehr zwischen zwei Geräten im Netzwerk durchlaufen muss, was die Latenzzeit verringert und ein höheres Maß an Redundanz bietet. Allerdings erhöht sich dadurch auch der Gesamtumfang der Glasfaserverkabelung im Rechenzentrum. In einer Leaf-Spine-Architektur ist die Größe des Netzwerks außerdem durch die Anzahl der an den Spine-Switches verfügbaren Ports begrenzt. Um vollständig blockierungsfrei zu sein, muss die Summe der Bandbreite aller Geräteverbindungen an jedem Leaf-Switch kleiner oder gleich der Summe der Bandbreite aller Uplinks zu den Spine-Switches sein.

Wenn ein Leaf-Switch beispielsweise zweiunddreißig 10-Gbit/s-Server-Ports (d. h. 320 Gbit/s-Kapazität) hat, benötigt er einen einzigen 400-Gbit/s-Uplink, zwei 200-Gbit/s-Uplinks, vier 100-Gbit/s-Uplinks oder acht 40-Gbit/s-Uplinks, um vollständig blockierungsfrei zu sein. Es ist leicht zu erkennen, dass die Anzahl der Glasfaser-Uplink-Verbindungen zunimmt!

Optimierung der Portauslastung

Um den Platzbedarf zu maximieren, niedrige Latenzzeiten beizubehalten und die Kosten zu optimieren, wird die Link-Aggregation über Break-out-Glasfaserbaugruppen immer häufiger eingesetzt. Es ist nicht ungewöhnlich, dass Unternehmenskunden einen einzigen 40-Gbit/s-Switch-Port an einem Leaf-Switch für die Verbindung mit vier 10-Gbit/s-Servern nutzen. Da die Switch-Geschwindigkeiten steigen, wird die Link-Aggregation eine noch bessere Port-Auslastung und Workload-Optimierung ermöglichen.

Im Januar 2020 umfasst die Ratifizierung von IEEE 802.3cm für den 400-Gbit/s-Betrieb über Multimode-Glasfaser 400GBASE-SR8 über 8 Paare und 400GBASE-SR4.2 über 4 Paare unter Verwendung von zwei verschiedenen Wellenlängen. Diese Anwendungen haben ein großes Marktpotenzial, da sie eine kostengünstige Aggregation ermöglichen, bei der ein einzelner 400-Gbit/s-Switchport mit bis zu acht 50-Gbit/s-Ports verbunden werden kann. Mit der Einführung von Vollduplex-Anwendungen wie 50GBASE-SR und Kurzwellenmultiplexing, das über die anstehende IEEE P802.3db 100 Gbit/s über Duplex-Glasfaser unterstützt, werden MTP-to-LC-Hybridbaugruppen unverzichtbar sein.

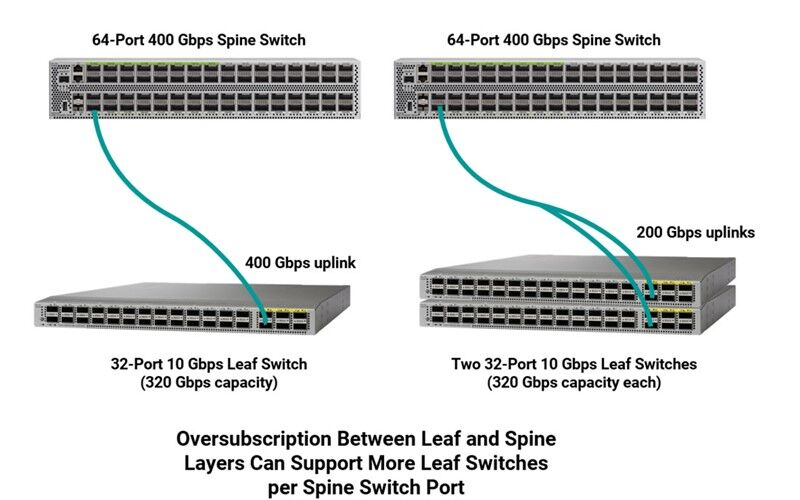

Einige Rechenzentren verwenden auch Link-Aggregation an der Leaf-Spine-Verbindung, um die Portauslastung zu maximieren. Anstatt vier 100-Gbit/s-Ports auf einem Spine-Switch für die Verbindung mit einem 10-Gbit/s-Leaf-Switch mit 32 Ports in einer Non-Blocking-Architektur zu verwenden, kann beispielsweise ein einziger 400-Gbit/s-Port eingesetzt werden. Die Entwickler von Rechenzentren sind jedoch bestrebt, die Switch-Dichte und den Bandbreitenbedarf sorgfältig auszubalancieren, um eine riskante Überbelegung und eine kostspielige Unterbelegung von Ressourcen auf jeder Switch-Ebene zu vermeiden.

Die Überzeichnung wird zwar nicht als völlig blockierungsfrei angesehen, aber es ist selten, dass alle Geräte gleichzeitig senden, so dass nicht alle Anschlüsse gleichzeitig die maximale Bandbreite benötigen. Bestimmte Anwendungen können auch eine gewisse Latenzzeit in Kauf nehmen. Oversubscription wird daher häufig eingesetzt, um die Vorteile von Verkehrsmustern zu nutzen, die auf mehrere Geräte verteilt sind, so dass Betreiber von Rechenzentren die Portdichte maximieren und Kosten und Komplexität reduzieren können. Netzwerkdesigner legen ihr Überbelegungs-Verhältnis auf der Grundlage von Anwendung, Verkehr, Platz und Kosten sorgfältig fest, wobei die meisten ein Verhältnis von 3:1 oder weniger zwischen Leaf- und Spine-Layer anstreben.

Wenn wir zum Beispiel auf das Beispiel eines Leaf-Switches mit zweiunddreißig 10-Gbit/s-Ports (320-Gbit/s-Kapazität) zurückkommen, kann es sinnvoll sein, statt eines 400-Gbit/s-Uplinks einen 200-Gbit/s-Uplink zum Spine-Switch mit einem Überbelegungsverhältnis von 320:200 (8:5) zu verwenden, was immer noch als geringes Überbelegungsverhältnis angesehen wird. Dadurch kann ein einzelner 400-Gbit/s-Port am Spine-Switch nun zwei Leaf-Switches unterstützen.

Diese Praktiken sind zwar ideal für die Auslastung der Switch-Ports, können aber zu komplexeren Verbindungen im Rechenzentrum führen. In Verbindung mit einer insgesamt größeren Menge an Glasfasern bedeutet dies, dass die Patching-Bereiche zwischen Leaf- und Spine-Switches dichter denn je sind. In einem sehr großen Rechenzentrum kann es sich um einen Patching-Bereich handeln, der mehrere Schränke und Tausende von Ports für die Verbindung von Geräten umfasst. Denken Sie an einen Meet-Me-Raum in einem Colocation-Center, in dem große Cross-Connects verwendet werden, um Mieterräume mit Service-Providern zu verbinden, oder an ein Cloud-Rechenzentrum, in dem Tausende von Switches Zehntausende von Servern verbinden. Das ist nicht nur eine Menge an zu verwaltenden Anschlüssen, sondern auch eine Menge an Kabeln in Kabelkanälen und Kabelmanagern.

Alles im Griff

In Umgebungen mit einer sehr hohen Dichte an Glasfaserverbindungen kann der Zugriff auf einzelne Ports zur Neukonfiguration von Verbindungen sehr schwierig sein, und wenn man mit den Fingern in diese engen Bereiche eindringt, um auf die Verriegelungen zum Entfernen von Steckern zuzugreifen, können benachbarte Verbindungen und Fasern beschädigt werden. Dies ist besonders problematisch, wenn ein Interconnect-Szenario implementiert wird, das den Zugriff auf kritische Verbindungen am Switch selbst erfordert – das Letzte, was Sie tun möchten, ist, einen teuren Switch-Port zu beschädigen, während Sie versuchen, eine einfache Verbindungsänderung vorzunehmen oder versehentlich die falsche(n) oder benachbarte(n) Verbindung(en) zu trennen. Gleichzeitig bedeutet die Implementierung verschiedener Aggregationsschemata und Verbindungen, die mit höheren Geschwindigkeiten laufen, dass Ausfallzeiten mehr Server beeinträchtigen können. Daher ist es wichtiger denn je, die korrekte End-to-End-Polarität aufrechtzuerhalten, um sicherzustellen, dass die Sendesignale an einem Ende des Kanals mit den Empfängern am anderen Ende übereinstimmen.

Glücklicherweise haben sich die Verkabelungslösungen weiterentwickelt, um das Kabelmanagement und den Polaritätswechsel im Rechenzentrum zu erleichtern. Für parallele optische Anwendungen in Switch-to-Switch-Verbindungen wie 8-Faser-200- und 400-Gbit/s-Verbindungen verwendet Siemon einen kleineren RazorCore™-Kabeldurchmesser von 2 mm auf 12- und 8-Faser-MTP-Faserbrücken. Um Platz auf den Wegen zwischen den Funktionsbereichen des Rechenzentrums zu sparen, verwendet Siemon auch RazorCore-Kabel mit kleinerem Durchmesser für MTP-Trunks. Siemon Multimode- und Singlemode-MTP-Jumper, Trunk-Assemblies und hybride MTP-to-LC-Assemblies sind außerdem mit dem MTP-Pro-Stecker ausgestattet, der die Möglichkeit bietet, die Polarität und das Geschlecht im Feld zu ändern.(Lesen Sie mehr über MTP Pro und Polarität).

Für Duplex-Verbindungen bieten die Siemon’s LC BladePatch® Jumper und Assemblies ein Ein-Rohr-Kabeldesign mit kleinerem Durchmesser, um die Überlastung der Pfade zu reduzieren und das Kabelmanagement in Umgebungen mit hoher Patching-Dichte zu vereinfachen. Der LC BladePatch ist in Multimode- und Singlemode-Ausführung erhältlich und verfügt über ein patentiertes Push-Pull-Boot-Design, das den Zugang zur Installation und Demontage vereinfacht, so dass der Zugang zu einer Verriegelung entfällt und Störungen oder Schäden an benachbarten Steckern vermieden werden. Der LC BladePatch lässt sich außerdem vor Ort leicht umpolen.

Tatsächlich hat Siemon kürzlich den LC BladePatch mit einem neuen einteiligen UniClick™-Boot verbessert, das die Gesamtgrundfläche weiter reduziert, um Umgebungen mit hoher Packungsdichte besser gerecht zu werden, und die Umpolung noch schneller und einfacher macht. Mit UniClick erfolgt die Umpolung mit einem einfachen Klick zum Entriegeln der Manschette und Drehen der Verriegelung ohne lose Teile und ohne Drehung des Steckers und der Faser, wodurch die Gefahr einer Beschädigung während des Prozesses ausgeschlossen wird. Die innovativen LC BladePatch-Duplex-Steckverbinder mit Push-Pull-Aktivierung sind auch für MTP-zu-LC BladePatch-Baugruppen erhältlich, um Breakouts für die zunehmende Link-Aggregation einfach zu ermöglichen.