Votre centre de données est-il à la hauteur des liaisons complexes en fibre optique à haute densité ?

Les technologies émergentes, le nombre croissant d’applications et la quantité de données qui exigent une bande passante élevée, une transmission à faible latence et des environnements hautement virtualisés font que la complexité des centres de données et les densités de câblage en fibre optique atteignent un niveau inégalé.

L’évolution de l’architecture entraîne une augmentation de l’infrastructure

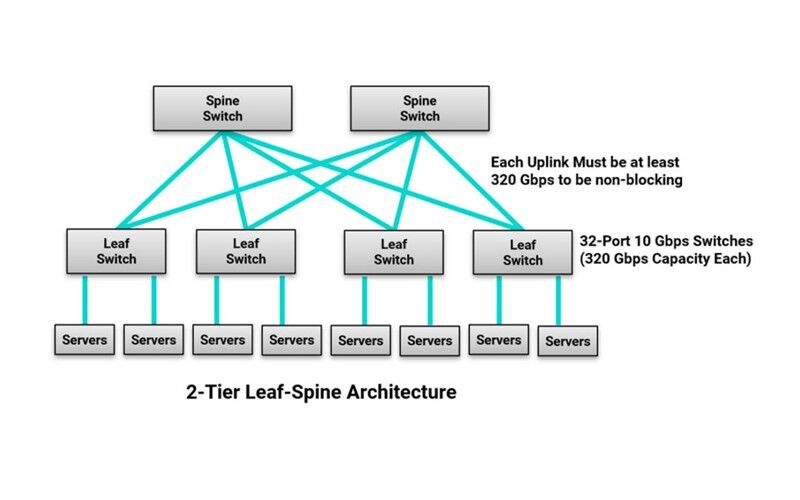

Si la densité de la fibre augmente dans les centres de données en raison de la quantité d’équipements nécessaires pour prendre en charge les applications émergentes et l’augmentation des données, elle est également stimulée par la virtualisation des serveurs qui permet de déplacer les charges de travail n’importe où dans le centre de données. La virtualisation croissante s’accompagne d’une migration rapide de l’architecture de commutation traditionnelle à trois niveaux, avec un schéma de trafic nord-sud, vers une architecture de commutation en épine dorsale, avec seulement un ou deux niveaux de commutation et un schéma de trafic est-ouest.

Dans une architecture feuille-épine, chaque commutateur feuille se connecte à chaque commutateur épine, de sorte qu’il n’y a jamais plus d’un commutateur entre deux commutateurs feuille sur le réseau. Cela réduit le nombre de sauts de commutateur que le trafic doit traverser entre deux appareils du réseau, ce qui réduit la latence et offre un niveau supérieur de redondance. Cependant, cela augmente également la quantité totale de câbles en fibre optique dans le centre de données. Dans une architecture feuille-épine, la taille du réseau est également limitée par le nombre de ports disponibles sur les commutateurs de l’épine dorsale, et pour qu’il n’y ait pas de blocage, la somme de la bande passante de toutes les connexions d’équipement sur chaque commutateur de l’épine dorsale doit être inférieure ou égale à la somme de la bande passante de toutes les liaisons montantes vers les commutateurs de l’épine dorsale.

Par exemple, si un commutateur à feuilles dispose de trente-deux ports de serveur à 10 Gbps (soit une capacité de 320 Gbps), il lui faudra une seule liaison montante de 400 Gbps, deux liaisons montantes de 200 Gbps, quatre liaisons montantes de 100 Gbps ou huit liaisons montantes de 40 Gbps pour ne pas être bloqué. Il est facile de voir comment le nombre de connexions de liaisons montantes en fibre optique augmente !

Optimiser l’utilisation des ports

Pour maximiser l’espace, maintenir une faible latence et optimiser les coûts, l’utilisation de l’agrégation de liens par le biais d’assemblages de fibres d’éclatement est en hausse. Il n’est pas rare de voir des entreprises utiliser un seul port de commutateur à 40 Gbps sur un commutateur à lames pour connecter quatre serveurs à 10 Gbps. Avec l’augmentation de la vitesse des commutateurs, l’agrégation de liens offrira une meilleure utilisation des ports et une optimisation de la charge de travail.

En janvier 2020, la ratification de la norme IEEE 802.3cm pour le fonctionnement à 400 Gbps sur fibre multimode comprend 400GBASE-SR8 sur 8 paires et 400GBASE-SR4.2 sur 4 paires en utilisant deux longueurs d’onde différentes. Ces applications ont un large potentiel commercial car elles permettent une agrégation rentable avec la possibilité de connecter un seul port de commutation de 400 Gbps à un maximum de huit ports de 50 Gbps. Avec l’introduction d’applications full duplex telles que 50GBASE-SR et le multiplexage par ondes courtes qui supporte 100 Gbps sur fibre duplex via la norme IEEE P802.3db, les assemblages hybrides MTP-to-LC seront essentiels.

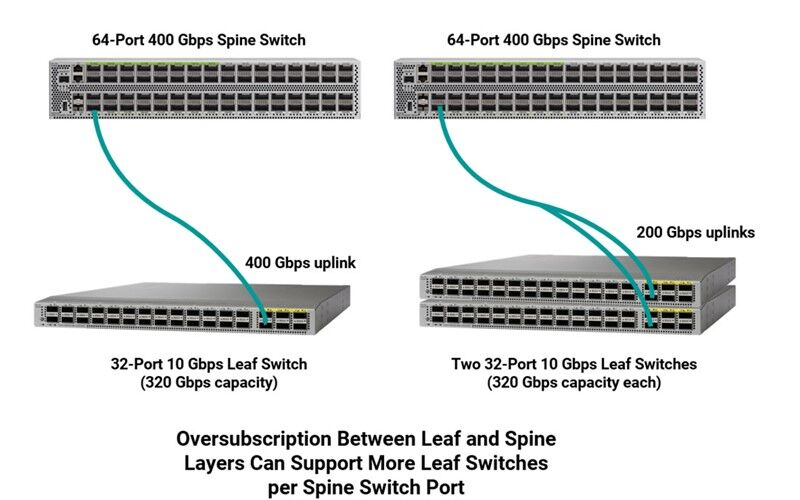

Certains centres de données utilisent également l’agrégation de liens au niveau de la connexion leaf-spine afin de maximiser l’utilisation des ports. Par exemple, au lieu d’utiliser quatre ports de 100 Gbps sur un commutateur spine pour se connecter à un commutateur leaf de 32 ports de 10 Gbps dans une architecture non bloquante, un seul port de 400 Gbps peut être utilisé. Toutefois, les concepteurs de centres de données s’efforcent d’équilibrer soigneusement la densité des commutateurs et les besoins en bande passante afin d’éviter un sur-abonnement risqué et un sous-abonnement coûteux des ressources à chaque couche de commutation.

Bien que la sursouscription ne soit pas considérée comme totalement non bloquante, il est rare que tous les appareils transmettent simultanément, de sorte que tous les ports n’ont pas besoin de la largeur de bande maximale en même temps. Certaines applications peuvent également présenter un risque de latence. La sursouscription est donc couramment utilisée pour tirer parti de modèles de trafic partagés entre plusieurs appareils, ce qui permet aux opérateurs de centres de données de maximiser la densité des ports et de réduire les coûts et la complexité. Les concepteurs de réseaux déterminent avec soin leurs ratios de sursouscription en fonction de l’application, du trafic, de l’espace et du coût, la plupart d’entre eux s’efforçant d’atteindre des ratios de 3:1 ou moins entre les couches feuille et épine dorsale.

Par exemple, si nous reprenons l’exemple d’un commutateur à feuilles avec trente-deux ports de 10 Gbps (capacité de 320 Gbps), au lieu de sous-abonner en utilisant une liaison montante de 400 Gbps, il peut être judicieux d’utiliser une liaison montante de 200 Gbps vers le commutateur spine avec un ratio de surabonnement de 320:200 (8:5), ce qui est toujours considéré comme un ratio de surabonnement faible. Cela permet à un seul port de 400 Gbps sur le commutateur spine de prendre en charge deux commutateurs leaf.

Bien que ces pratiques soient idéales pour l’utilisation des ports des commutateurs, elles peuvent rendre les liens des centres de données plus complexes. Combiné à une augmentation générale de la quantité de fibres, cela signifie que les zones de brassage entre les commutateurs leaf et spine sont plus denses que jamais. Dans un très grand centre de données, nous pourrions parler d’une zone de brassage qui englobe plusieurs armoires et des milliers de ports pour la connexion des équipements. Pensez à une salle de réunion dans une colocation où de grandes connexions croisées sont utilisées pour connecter les espaces des locataires aux fournisseurs de services, ou à un centre de données en nuage où des milliers de commutateurs connectent des dizaines de milliers de serveurs. Non seulement cela fait beaucoup de ports à gérer, mais cela fait aussi beaucoup de câbles dans les chemins de câbles et les gestionnaires de câbles.

Tout gérer

Dans les environnements de brassage de fibres à très haute densité, il peut être très difficile d’accéder aux ports individuels pour reconfigurer les connexions, et le fait de mettre les doigts dans ces espaces restreints pour accéder aux loquets afin de retirer les connecteurs peut endommager les connexions et les fibres adjacentes. Ceci est particulièrement préoccupant lors du déploiement d’un scénario d’interconnexion qui peut nécessiter l’accès à des connexions critiques sur le commutateur lui-même – la dernière chose à faire est d’endommager un port de commutateur coûteux en essayant d’effectuer un simple changement de connexion ou de déconnecter par inadvertance la mauvaise connexion ou les connexions adjacentes. Dans le même temps, la mise en œuvre de divers schémas d’agrégation et de liens fonctionnant à des vitesses plus élevées signifie que les temps d’arrêt peuvent avoir un impact sur un plus grand nombre de serveurs. Il est donc plus important que jamais de maintenir une polarité correcte de bout en bout afin de garantir que les signaux de transmission à une extrémité d’un canal correspondent aux récepteurs à l’autre extrémité.

Heureusement, les solutions de câblage ont évolué pour faciliter la gestion des câbles et les changements de polarité dans le centre de données. Pour les applications optiques parallèles dans les liens de commutateur à commutateur comme les 200 et 400 Gbps à 8 fibres, Siemon utilise un câble RazorCore™ plus petit de 2 mm de diamètre sur les cavaliers de fibre MTP à 12 et 8 fibres. Pour économiser de l’espace de cheminement entre les zones fonctionnelles du centre de données, Siemon utilise également un câblage RazorCore de plus petit diamètre sur les trunks MTP. Siemon jumpers MTP multimode et monomode, trunk assemblies et hybrides MTP-to-LC sont également dotés du connecteur MTP Pro qui offre la possibilité de changer la polarité et le genre sur le terrain.(en savoir plus sur le MTP Pro et la polarité).

Pour les connexions duplex, les cavaliers et assemblages LC BladePatch® de Siemon offrent une conception de câble uni-tube de plus petit diamètre afin de réduire l’encombrement des voies et de simplifier la gestion des câbles dans les environnements de patch à haute densité. Disponible en multimode et monomode, le LC BladePatch à faible encombrement offre une conception brevetée d’amorçage push-pull qui facilite l’accès à l’installation et au retrait, éliminant le besoin d’accéder à un loquet et évitant toute perturbation ou dommage aux connecteurs adjacents. Le LC BladePatch permet également d’inverser facilement la polarité sur le terrain.

En fait, Siemon a récemment amélioré le LC BladePatch avec une nouvelle gaine UniClick™ en une seule pièce qui réduit encore l’empreinte globale pour mieux s’adapter aux environnements à haute densité et qui rend l’inversion de polarité encore plus rapide et plus facile. Avec UniClick, l’inversion de polarité ne nécessite qu’un simple clic pour déverrouiller le sabot et faire pivoter le loquet sans pièces détachées et sans faire tourner le connecteur et la fibre, ce qui élimine tout risque de dommage au cours du processus. Les connecteurs duplex LC BladePatch innovants activés par push-pull sont également disponibles sur les assemblages MTP vers LC BladePatch afin d’accommoder facilement les ruptures pour l’agrégation de liens en tendance.